Repräsentationslernen und Kausalität: Theorie, Praxis und Implikationen für die mechanistische Interpretierbarkeit

Florent Draye – Hector Fellow Bernhard Schölkopf

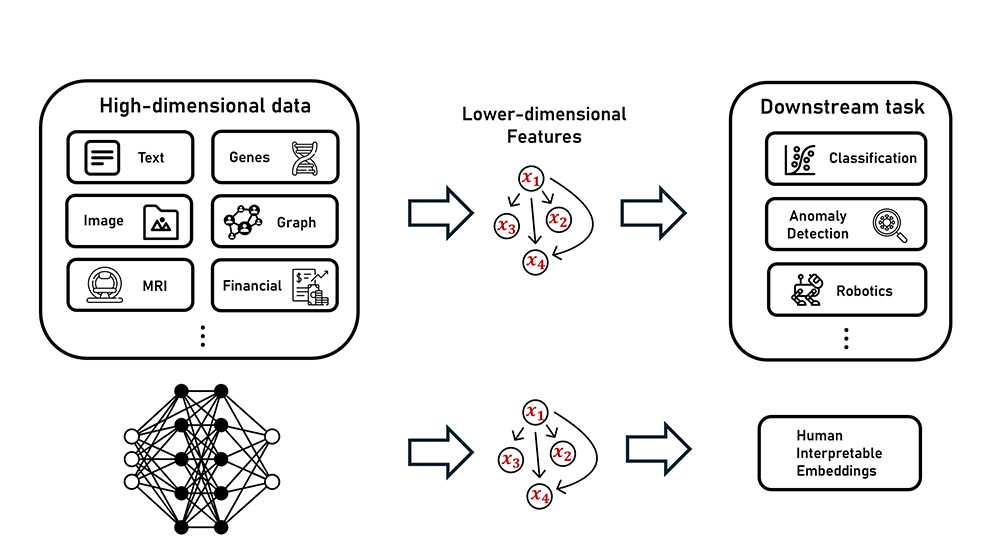

Meine Forschungsinteressen liegen an der Schnittstelle von Repräsentationslernen, Kausalität und generativen Modellen. Mein Ziel ist es, zur Entwicklung von Methoden beizutragen, die aussagekräftige und interpretierbare Merkmale aus hochdimensionalen Datensätzen extrahieren, wobei der Schwerpunkt auf der Entdeckung übergeordneter, kausal verbundener Faktoren liegt, die eine sinnvolle Semantik der Daten beschreiben. Dies wiederum kann uns helfen, tiefere Einblicke in die Repräsentationen zu gewinnen, die in fortgeschrittenen generativen Modellen zu finden sind, insbesondere in Basismodellen und LLMs, mit dem Ziel, deren Effizienz und Sicherheit zu verbessern.

Tiefe neuronale Netze haben aufgrund ihrer Fähigkeit, aussagekräftige Merkmale aus komplexen, hochdimensionalen Daten zu lernen, bei verschiedenen Aufgaben große Erfolge gezeigt. Ihre starke Abhängigkeit von großen Mengen an Kennzeichnungen zum effektiven Erlernen dieser Merkmale schränkt jedoch ihre Anwendbarkeit in Szenarien des unüberwachten Lernens ein. Mit dem Repräsentationslernen wird versucht, diese hochdimensionalen Datensätze ohne Überwachung in niedriger dimensionierte Repräsentationen umzuwandeln. Durch die Identifizierung des richtigen Raums, in dem Schlussfolgerungen und Berechnungen durchgeführt werden können, ermöglicht es auch die Entdeckung interpretierbarer Muster und Merkmale in den Daten. In meiner Promotion arbeite ich an der Schnittstelle von Repräsentationslernen und Kausalität. Ich erforsche, wie man Datenrepräsentationen lernt, die sowohl interpretierbar als auch kontrollierbar sind, und konzentriere mich dabei auf die Identifizierung geeigneter High-Level-Abstraktionen der Daten, auf denen man kausale Strukturen modellieren kann.

Parallel dazu haben Basismodelle wie Large-Language-Modelle (LLMs) in letzter Zeit stark an Aufmerksamkeit gewonnen. Diese neuronalen Netze, die auf massiven Datensätzen mit Milliarden von Parametern trainiert werden, werden oft als „Black Boxes“ betrachtet, da wir ihre zugrunde liegenden Berechnungsprinzipien nicht verstehen. Ein tieferes Verständnis der von diesen neuronalen Netzen implementierten Algorithmen ist von entscheidender Bedeutung, nicht nur für den wissenschaftlichen Fortschritt, sondern auch für die Verbesserung ihrer Effizienz und Sicherheit. Um diese Herausforderung zu bewältigen, integriere ich Konzepte aus dem Bereich der Kausalität und des Repräsentationslernens, um ein mechanistisches Verständnis der hochdimensionalen Datenrepräsentationen zu entwickeln, die in diesen fortschrittlichen generativen Modellen zu finden sind.

Teil 1. Repräsentationslernen / kausales Repräsentationslernen. Teil 2. Aufbau eines mechanistischen Verständnisses der hochdimensionalen Datenrepräsentationen, die in Grundmodellen zu finden sind.

Florent Draye

Max-Planck-Institut für Intelligente SystemeBetreut durch

Bernhard Schölkopf

Informatik, Physik & MathematikHector Fellow seit 2018