Quanteninformationsverarbeitung mit skalierbarer Halbleiter-Spin-Qubit Chips

Dominic Barthlott - Hector Fellow Wolfgang Wernsdorfer

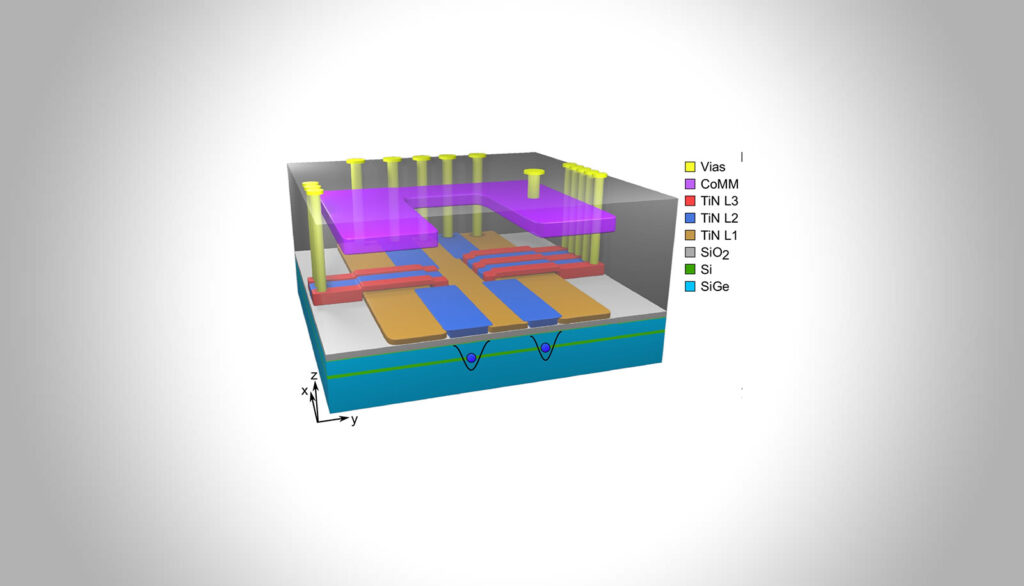

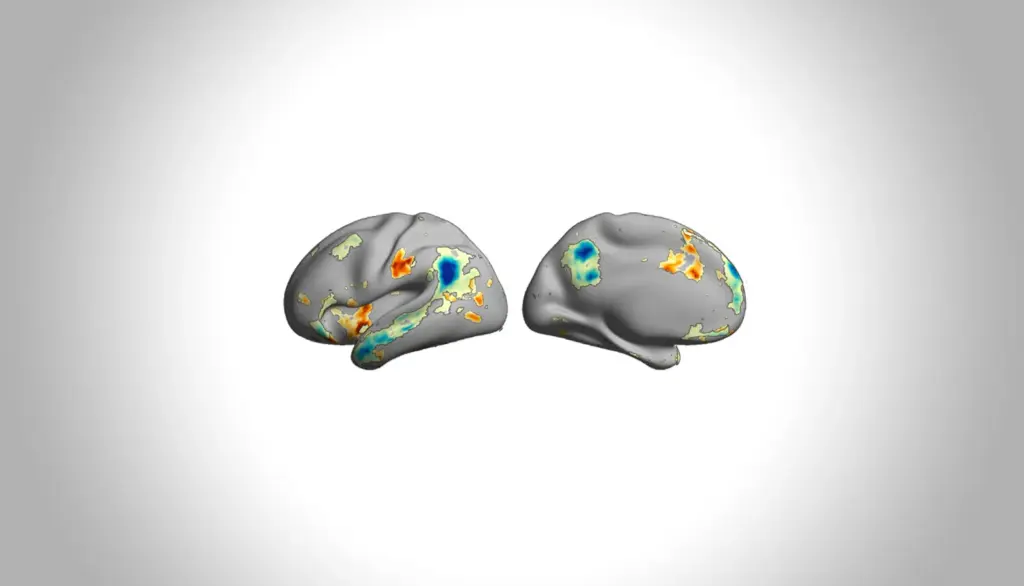

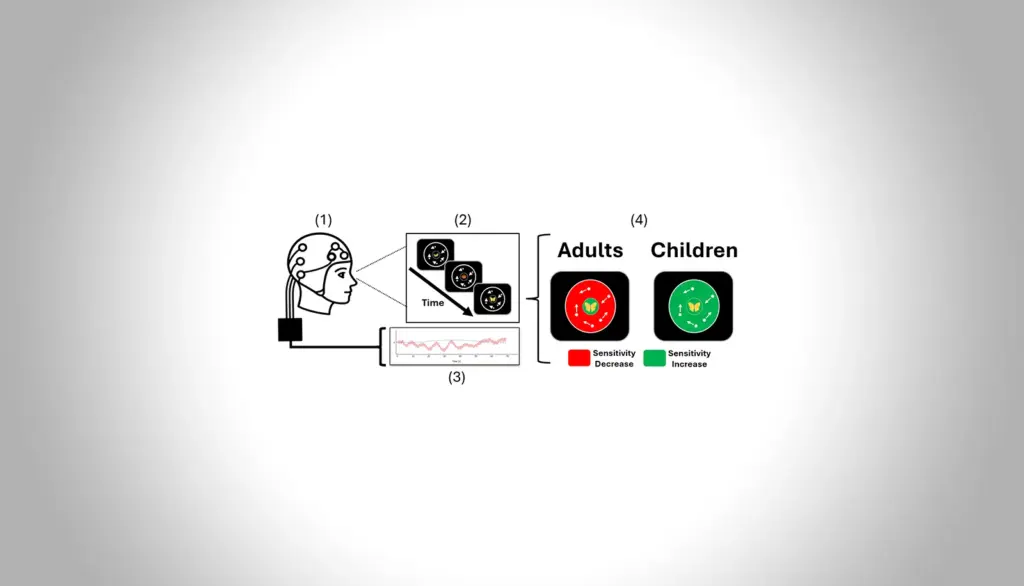

Quantencomputer besitzen das Potenzial, klassische Probleme wie komplexe Simulations-, Optimierungs- und Kryptografieaufgaben erheblich zu beschleunigen, setzen dafür jedoch skalierbare und robuste Qubit-Technologien voraus. Halbleiter-Spin-Qubits vereinen lange Kohärenzzeiten mit etablierten, industriellen Fertigungsprozessen. Dieses Projekt fokussiert sich auf die Implementierung präziser Zwei-Qubit-Gatter, welche dann zu Multi-Qubit-Arrays erweitert und deren Leistungsfähigkeit mit Quantenalgorithmen und umfassenden Benchmarking-Verfahren validiert werden.